k8s提交spark应用消费kafka数据写入elasticsearch7

最佳答案 问答题库668位专家为你答疑解惑

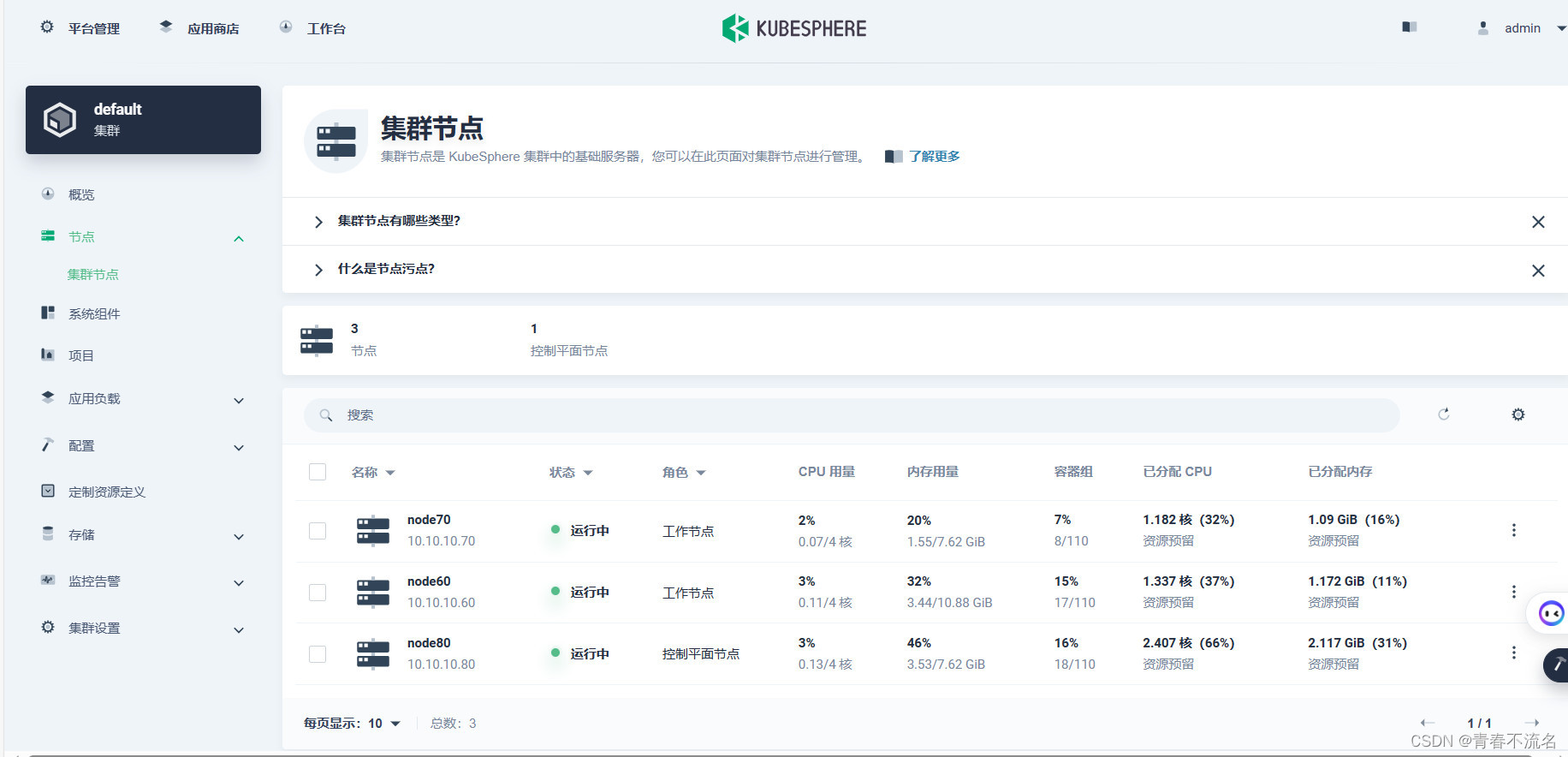

一、k8s集群环境

k8s 1.23版本,三个节点,容器运行时使用docker。

spark版本时3.3.3

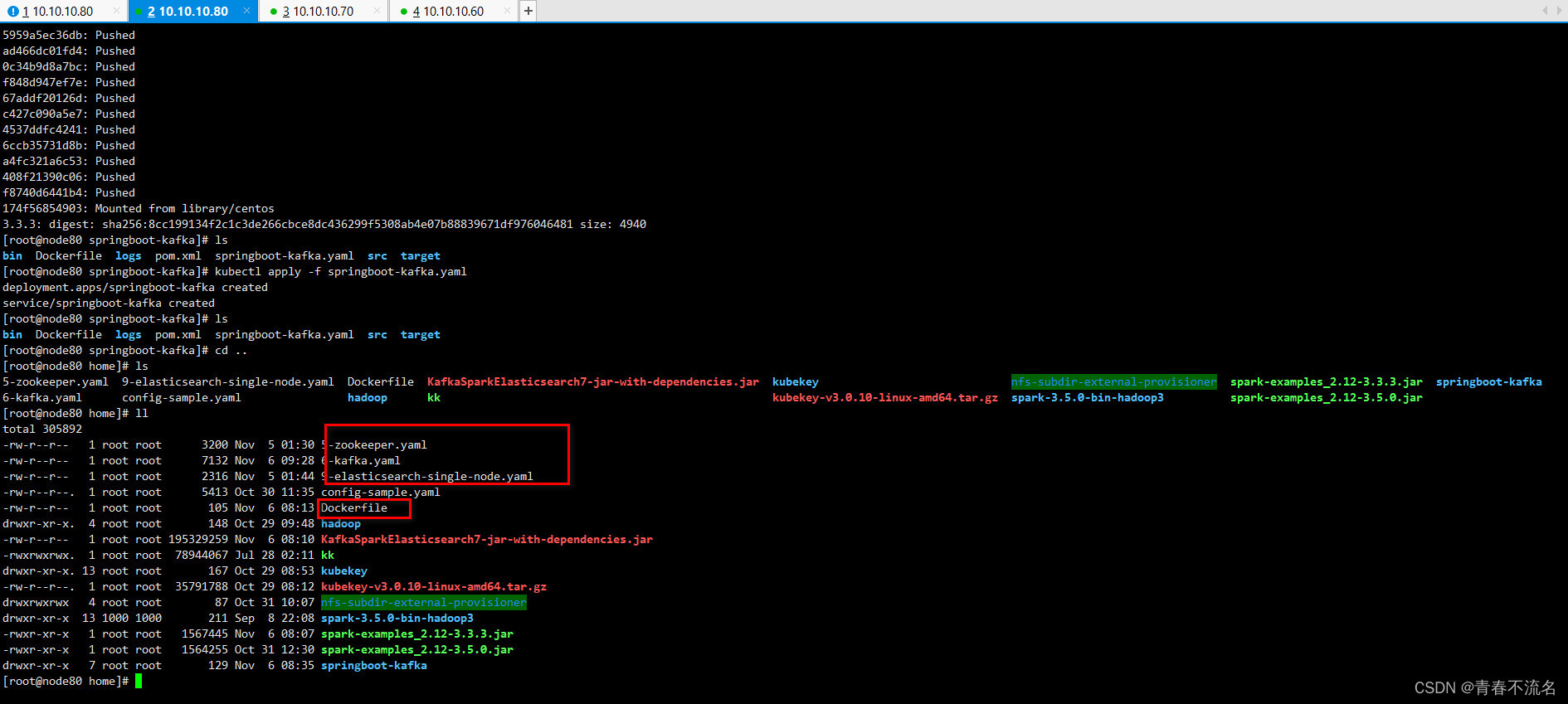

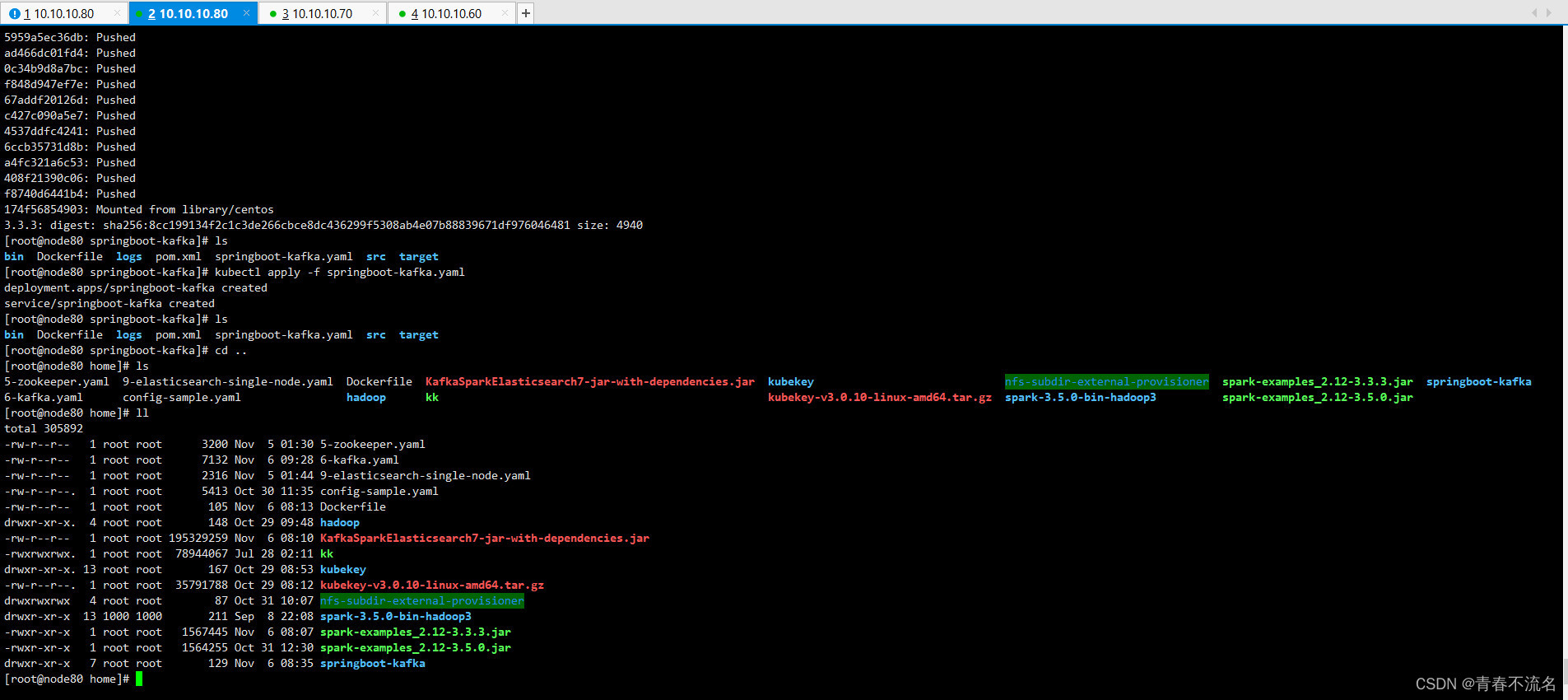

k8s部署单节点的zookeeper、kafka、elasticsearch7

二、spark源码

https://download.csdn.net/download/TT1024167802/88509398

命令行提交方式

/opt/module/spark-3.3.3/bin/spark-submit --name KafkaSparkElasticsearch7 --verbose --master k8s://https://10.10.10.80:6443 --deploy-mode cluster --conf spark.network.timeout=300 --conf spark.executor.instances=3 --conf spark.driver.cores=1 --conf spark.executor.cores=1 --conf spark.driver.memory=1024m --conf spark.executor.memory=1024m --conf spark.kubernetes.namespace=apache-spark --conf spark.kubernetes.container.image.pullPolicy=IfNotPresent --conf spark.kubernetes.container.image=zhxl1989/spark-demo:3.3.3 --conf spark.kubernetes.authenticate.driver.serviceAccountName=spark-service-account --conf spark.kubernetes.authenticate.executor.serviceAccountName=spark-service-account --conf spark.driver.extraJavaOptions="-Dio.netty.tryReflectionSetAccessible=true" --conf spark.executor.extraJavaOptions="-Dio.netty.tryReflectionSetAccessible=true" --class com.example.cloud.KafkaSparkElasticsearch7 local:///opt/spark/examples/jars/KafkaSparkElasticsearch7-jar-with-dependencies.jar 3000

基于apache/spark:3.3.3镜像构建,将KafkaSparkElasticsearch7-jar-with-dependencies.jar添加到镜像容器的/opt/spark/examples/jars/目录下。

main类名

com.example.cloud.KafkaSparkElasticsearch7

k8s主节点入口

k8s://https://10.10.10.80:6443

设置响应的名称空间及account 、rule权限。

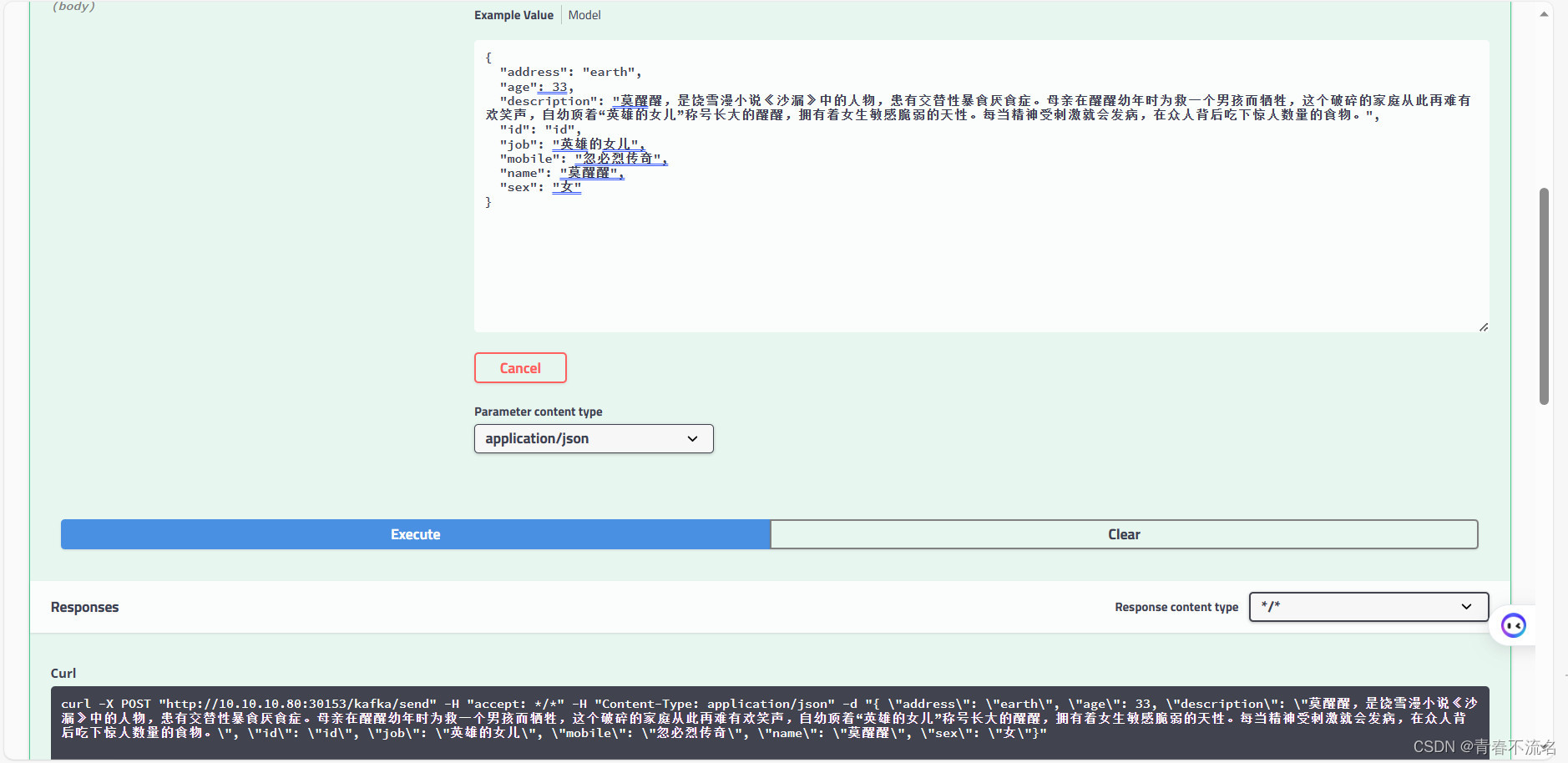

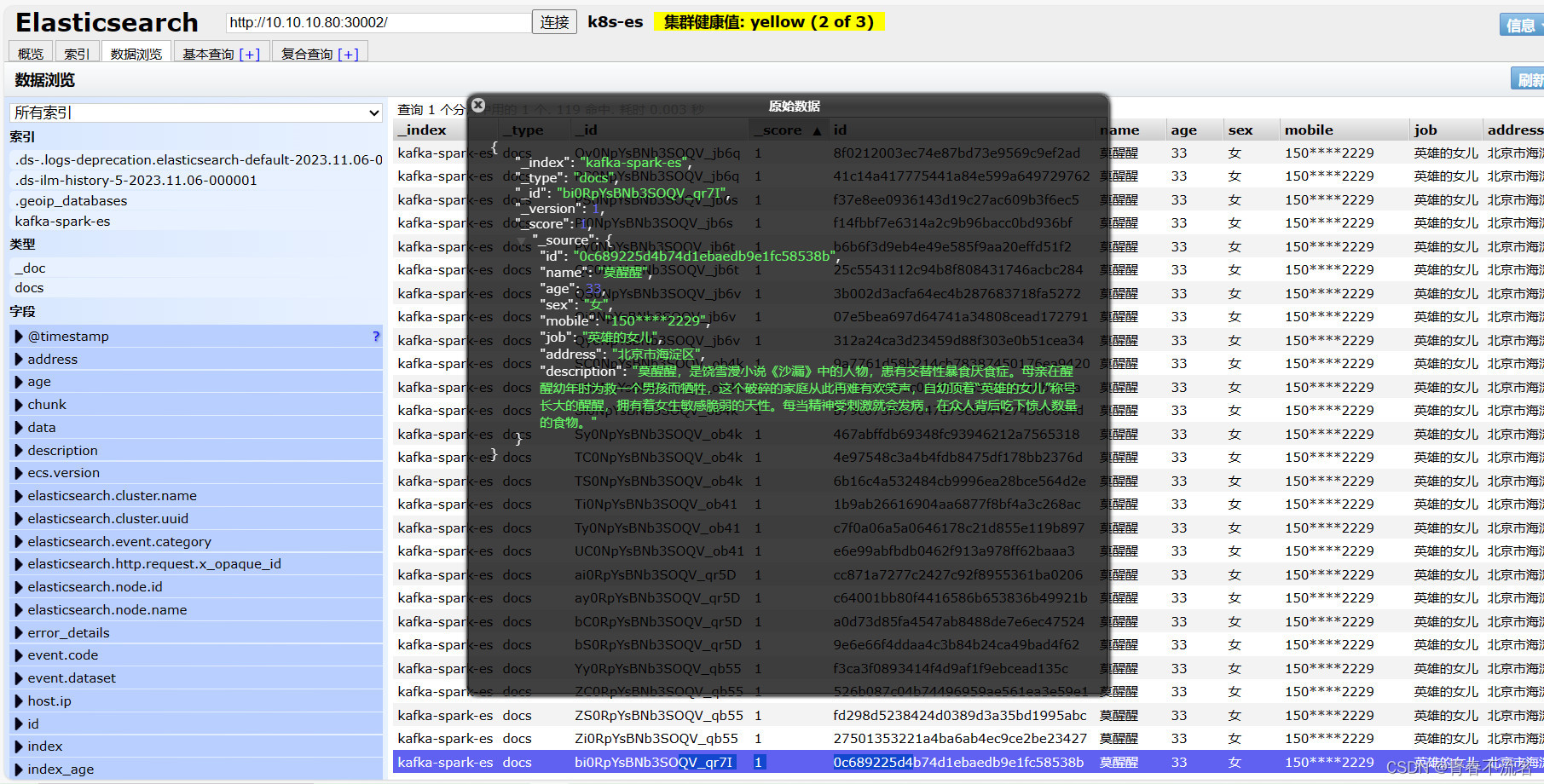

三、运行效果

99%的人还看了

相似问题

- 〖大前端 - 基础入门三大核心之JS篇㊲〗- DOM改变元素节点的css样式、HTML属性

- Java 算法篇-链表的经典算法:判断回文链表、判断环链表与寻找环入口节点(“龟兔赛跑“算法实现)

- 代码随想录二刷 | 链表 | 删除链表的倒数第N个节点

- 节点导纳矩阵

- bhosts 显示节点 “unreach“ 状态

- 电子电器架构 —— 车载网关边缘节点总线转换

- 〖大前端 - 基础入门三大核心之JS篇㊳〗- DOM访问元素节点

- 第四天||24. 两两交换链表中的节点 ● 19.删除链表的倒数第N个节点 ● 面试题 02.07. 链表相交 ● 142.环形链表II

- CS224W5.1——消息传递和节点分类

- Vue报错解决Error in v-on handler: “Error: 无效的节点选择器:#div1“

猜你感兴趣

版权申明

本文"k8s提交spark应用消费kafka数据写入elasticsearch7":http://eshow365.cn/6-35871-0.html 内容来自互联网,请自行判断内容的正确性。如有侵权请联系我们,立即删除!