chatGPT培训老师AIGC培训讲师叶梓:大模型这么火,我们在使用时应该关注些什么?-6

最佳答案 问答题库578位专家为你答疑解惑

以下为叶老师讲义分享:

P25-P29

提示工程的模式

节省计算资源:

在微调过程中,不需要重新训练整个模型,因此可以节省计算资源。

提高特定任务上的性能:

通过微调,模型可以适应特定任务的语言特征和模式,从而提高模型的性能。

保留模型的通用性:

预训练模型具有较高的通用性能,微调可以帮助模型适应特定任务的语言特征和模式,从而提高模型的通用性。

减少数据需求:

预训练模型已经过大量训练,因此在微调过程中可以使用较少的数据。

微调大模型的意义

节省计算资源:

在微调过程中,不需要重新训练整个模型,因此可以节省计算资源。

提高特定任务上的性能:

通过微调,模型可以适应特定任务的语言特征和模式,从而提高模型的性能。

保留模型的通用性:

预训练模型具有较高的通用性能,微调可以帮助模型适应特定任务的语言特征和模式,从而提高模型的通用性。

减少数据需求:

预训练模型已经过大量训练,因此在微调过程中可以使用较少的数据。

微调大模型的方法(Adapter-Tuning)

- 微调时冻结预训练模型的主体,由Adapter模块学习特定下游任务的知识。

- Adapter调优的参数量大约为LM参数的3.6%。

Prefix Tuning只是在每个任务前有少量的prefix的参数,

- 比如翻译任务,可以在每句话的前面加上“翻译:”来引导模型进行翻译功能。

- Prefix Tuning参数规模约为LM模型整体规模的0.1%。

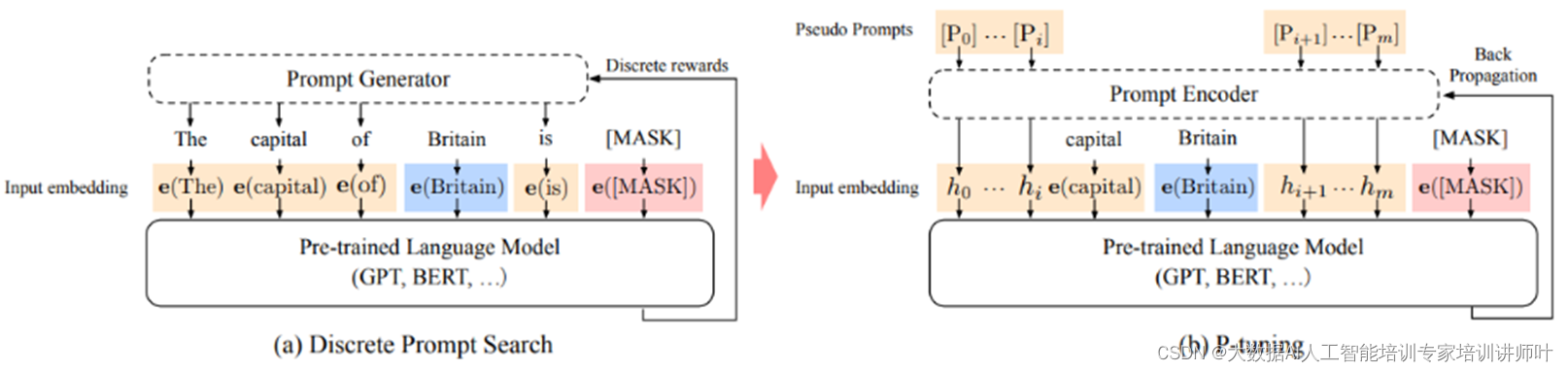

因为离线的Prompt对于连续的神经网络只是次优解,prompt的词之间是彼此关联的,需要将其关联起来。

于是,P-Tuning将一些伪prompt输入至LSTM中,然后利用LSTM的输出向量来替代原始的prompt token,然后一起输入至预训练语言模型中。

LSTM和随着预训练语言模型一起训练。

chatGPT讲师AIGC讲师叶梓:大模型这么火,我们在使用时应该关注些什么?未完,下一章继续……

99%的人还看了

相似问题

- 最新AIGC创作系统ChatGPT系统源码,支持最新GPT-4-Turbo模型,支持DALL-E3文生图,图片对话理解功能

- 思维模型 等待效应

- FinGPT:金融垂类大模型架构

- 人工智能基础_机器学习044_使用逻辑回归模型计算逻辑回归概率_以及_逻辑回归代码实现与手动计算概率对比---人工智能工作笔记0084

- Pytorch完整的模型训练套路

- Doris数据模型的选择建议(十三)

- python自动化标注工具+自定义目标P图替换+深度学习大模型(代码+教程+告别手动标注)

- ChatGLM2 大模型微调过程中遇到的一些坑及解决方法(更新中)

- Python实现WOA智能鲸鱼优化算法优化随机森林分类模型(RandomForestClassifier算法)项目实战

- 扩散模型实战(十一):剖析Stable Diffusion Pipeline各个组件

猜你感兴趣

版权申明

本文"chatGPT培训老师AIGC培训讲师叶梓:大模型这么火,我们在使用时应该关注些什么?-6":http://eshow365.cn/6-36254-0.html 内容来自互联网,请自行判断内容的正确性。如有侵权请联系我们,立即删除!