已解决

LLM之Prompt(一):5个Prompt高效方法在文心一言3.5的测试对比

来自网友在路上 182882提问 提问时间:2023-11-07 21:04:36阅读次数: 82

最佳答案 问答题库828位专家为你答疑解惑

在Effective Prompt: 编写高质量Prompt的14个有效方法文中我们了解了14个编写Prompt的方法(非常感谢原作者),那么这些Prompt在具体大模型中的效果如何呢?本文以百度文心一言3.5版本大模型在其中5个方法上做个测试对比。

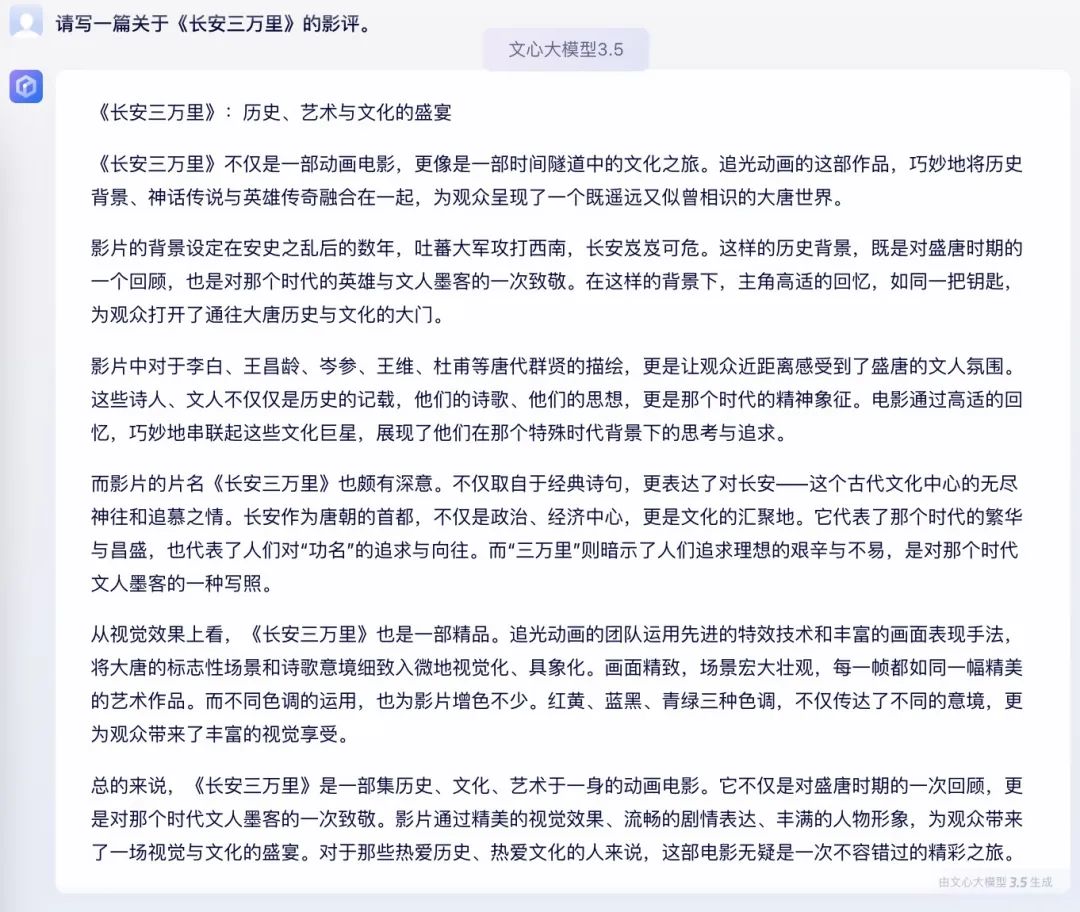

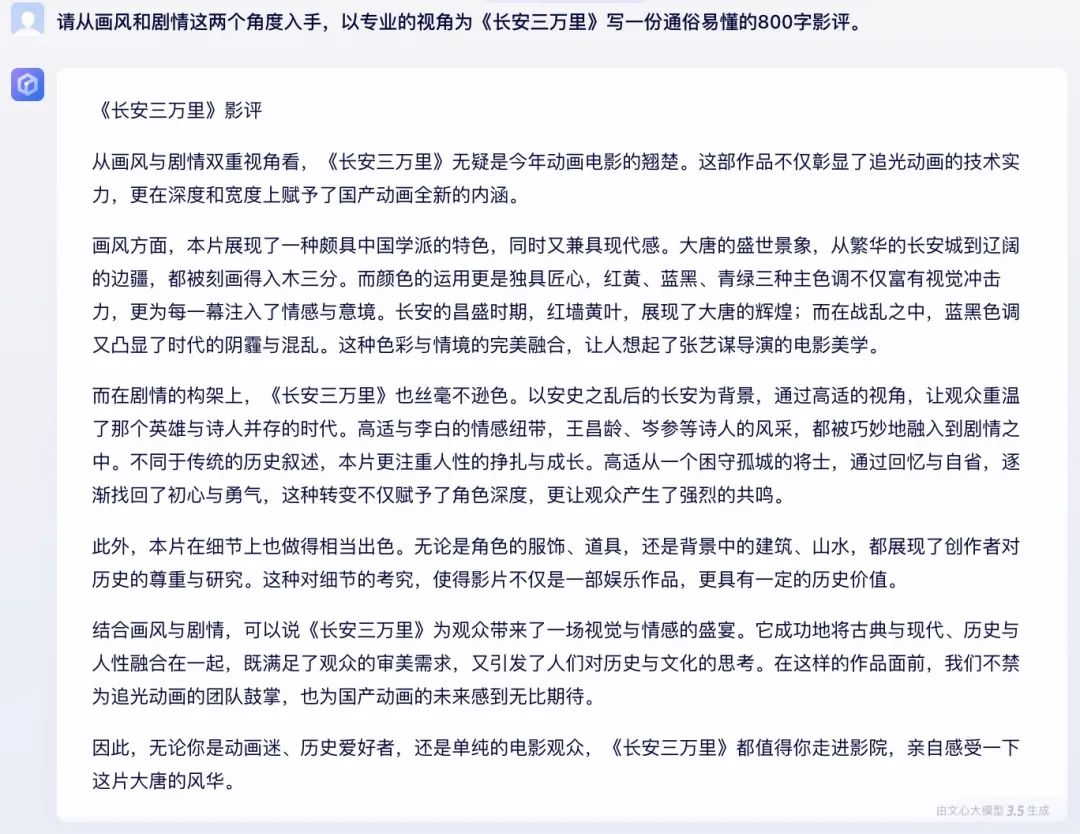

第1条:明确“好结果”的标准

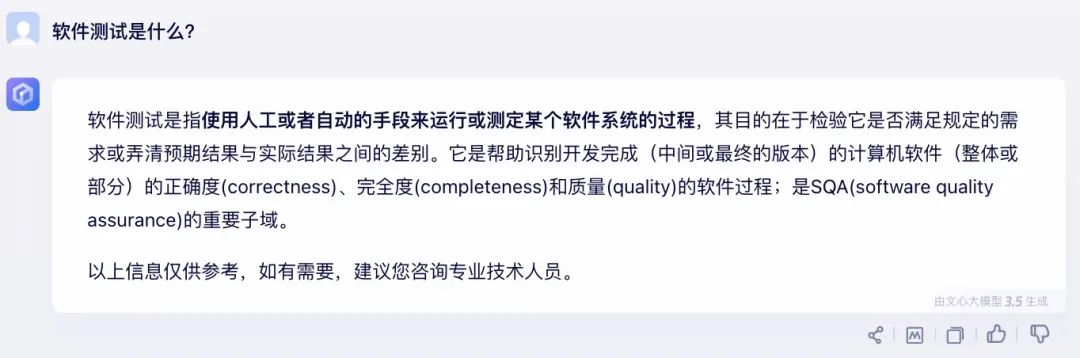

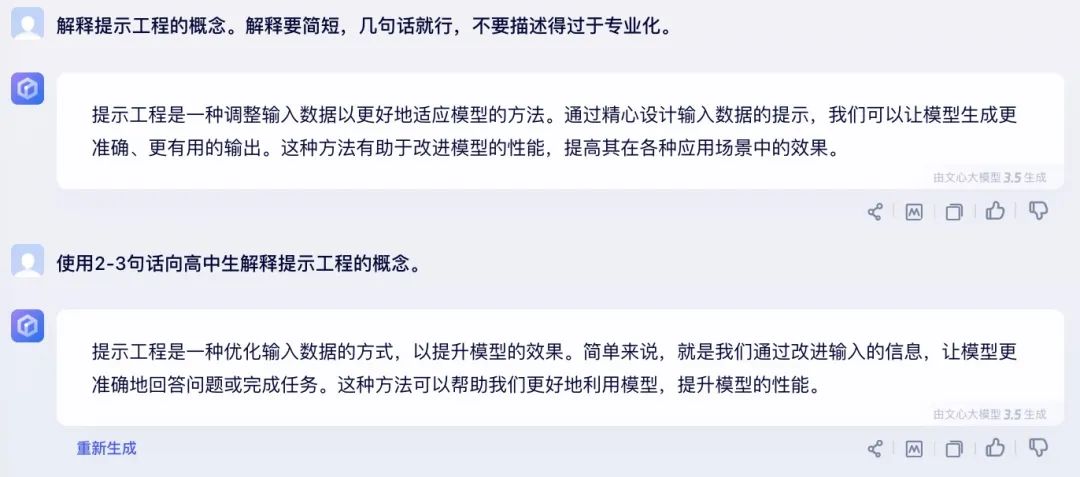

第2条:精准表达任务指令

第3条:为否定句设置兜底策略

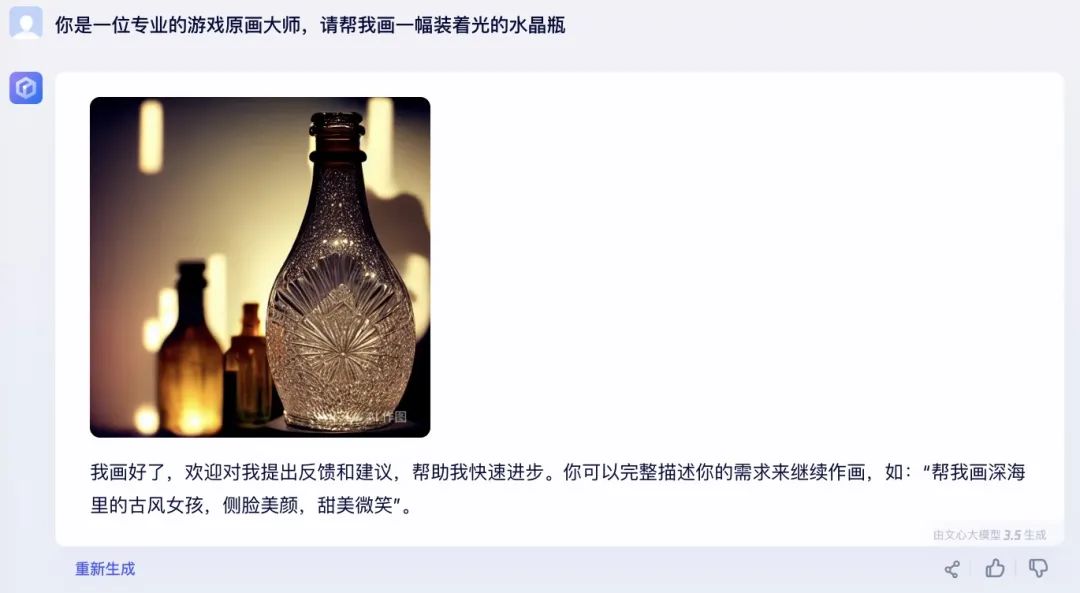

第4条:指定模型所扮演的角色

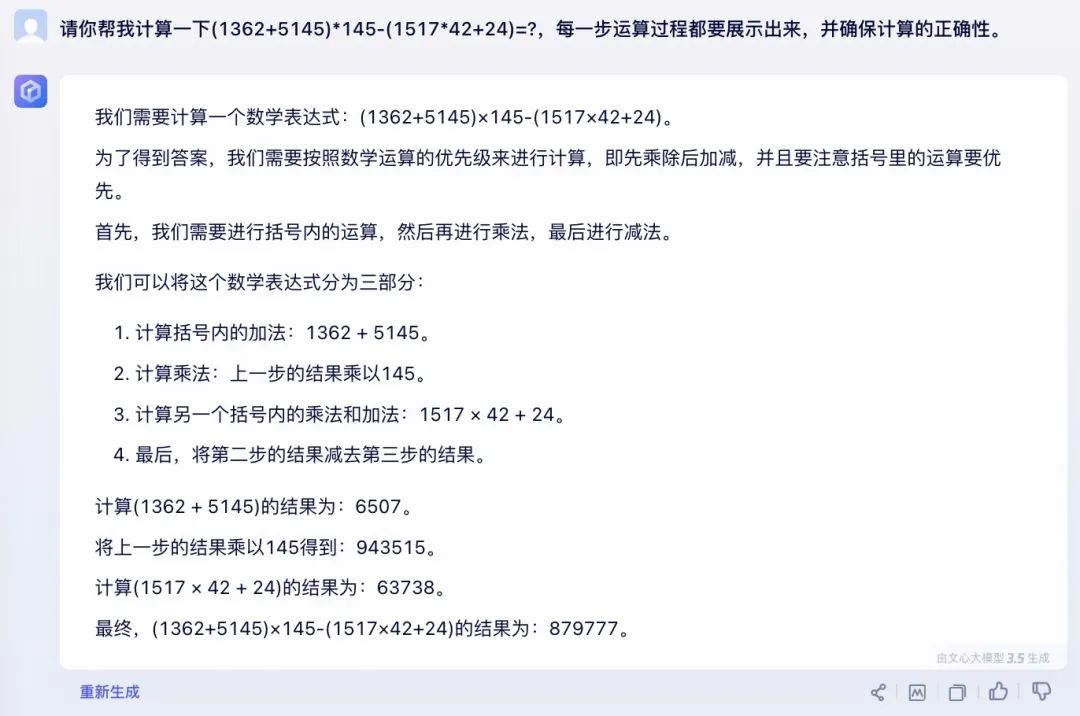

第5条:使用思维链

直接计算也可以得出正确的结果,不经感叹:文心一言数学能力真强👍🏻啊

查看全文

99%的人还看了

相似问题

- 最新AIGC创作系统ChatGPT系统源码,支持最新GPT-4-Turbo模型,支持DALL-E3文生图,图片对话理解功能

- 思维模型 等待效应

- FinGPT:金融垂类大模型架构

- 人工智能基础_机器学习044_使用逻辑回归模型计算逻辑回归概率_以及_逻辑回归代码实现与手动计算概率对比---人工智能工作笔记0084

- Pytorch完整的模型训练套路

- Doris数据模型的选择建议(十三)

- python自动化标注工具+自定义目标P图替换+深度学习大模型(代码+教程+告别手动标注)

- ChatGLM2 大模型微调过程中遇到的一些坑及解决方法(更新中)

- Python实现WOA智能鲸鱼优化算法优化随机森林分类模型(RandomForestClassifier算法)项目实战

- 扩散模型实战(十一):剖析Stable Diffusion Pipeline各个组件

猜你感兴趣

版权申明

本文"LLM之Prompt(一):5个Prompt高效方法在文心一言3.5的测试对比":http://eshow365.cn/6-34742-0.html 内容来自互联网,请自行判断内容的正确性。如有侵权请联系我们,立即删除!