论文阅读——BERT

最佳答案 问答题库508位专家为你答疑解惑

ArXiv:https://arxiv.org/abs/1810.04805

github:GitHub - google-research/bert: TensorFlow code and pre-trained models for BERT

一、模型及特点:

1、模型:

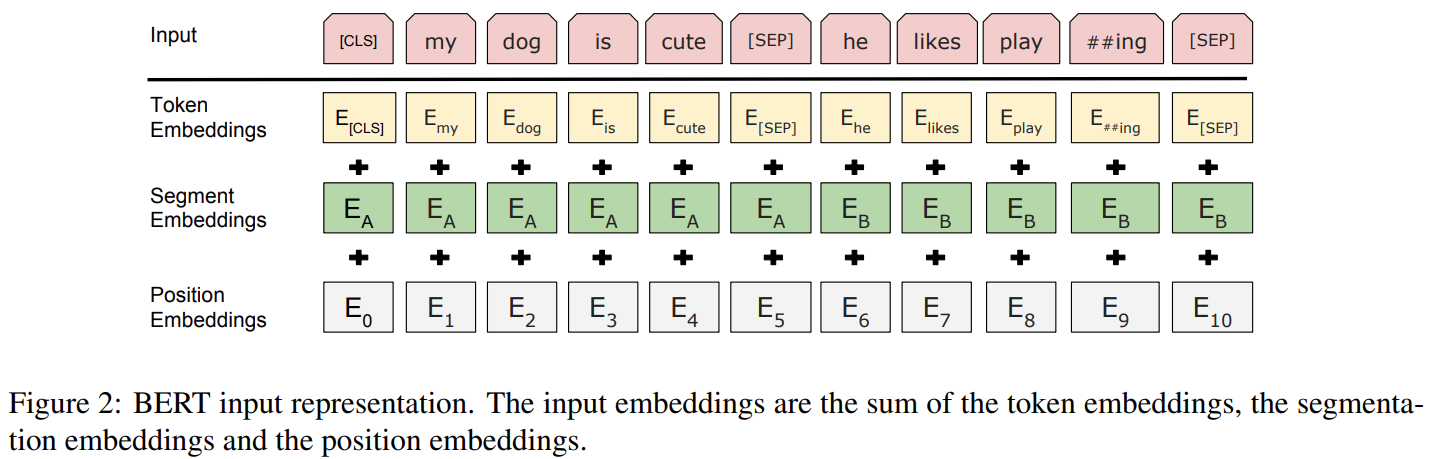

深层双向transformer encoder结构

BERT-BASE:(L=12, H=768, A=12)

BERT-LARGE:(L=24, H=1024, A=16)

2、特点:

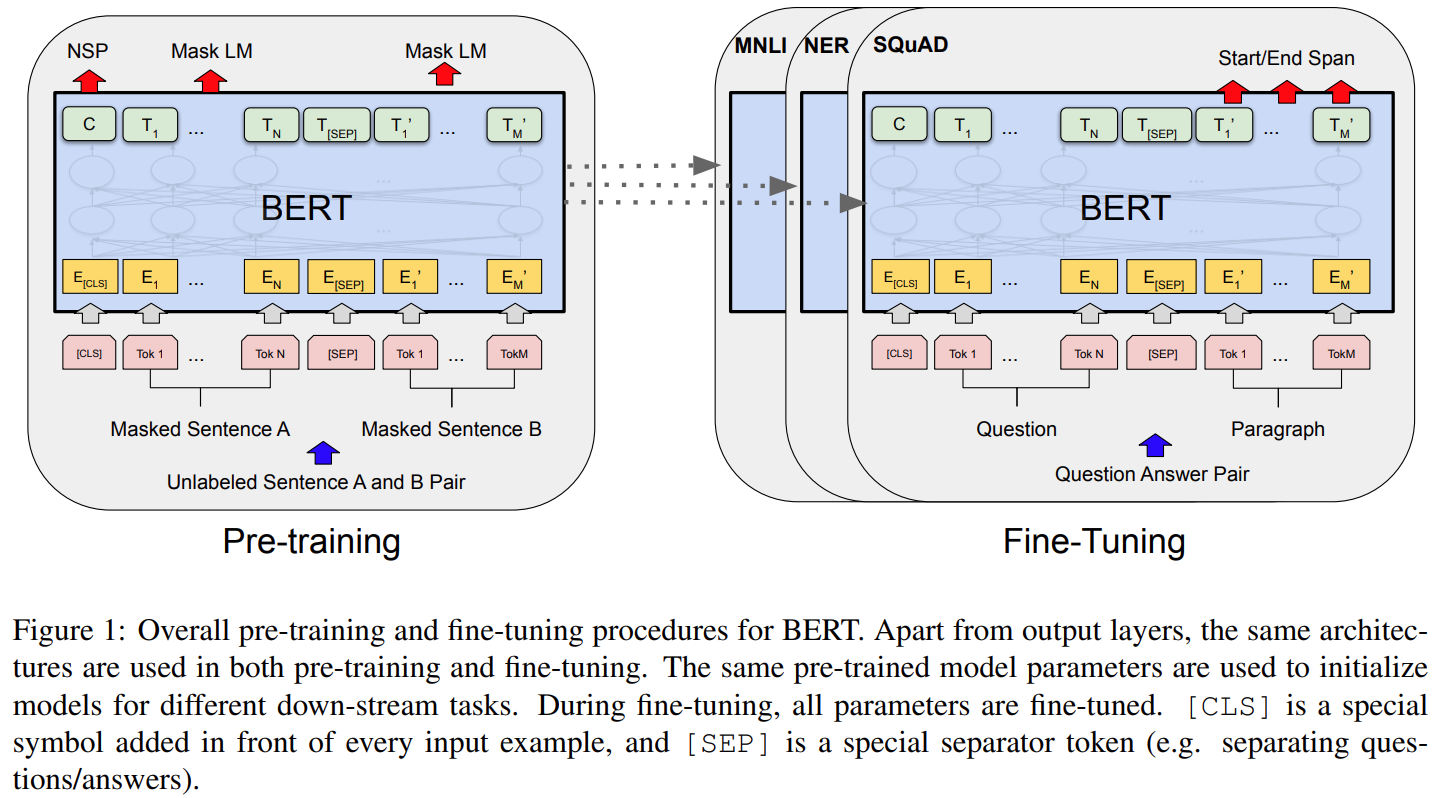

不同任务使用统一架构,预训练和微调只有很小不同

双向预训练模型——通过训练MLM子任务获得

二、训练:两阶段训练——预训练和微调

1、预训练:

(1)训练设置

1)在无标签、不同任务上训练

2)训练两个子任务:Masked LM(MLM),Next Sentence Prediction (NSP)

MLM:为了双向模型

损失函数:cross entropy loss

mask:随机选择15%的位置,被选择的位置有80%mask,10%随机token,10%unchanged。训练中位置不变,但是由于每个句子不一样,所以预测的token也不是每次都一样。

NSP:为了理解句子关系

(2)数据:

BooksCorpus (800M words)、English Wikipedia (2,500M words) extract only the text passages and ignore lists, tables, and headers.

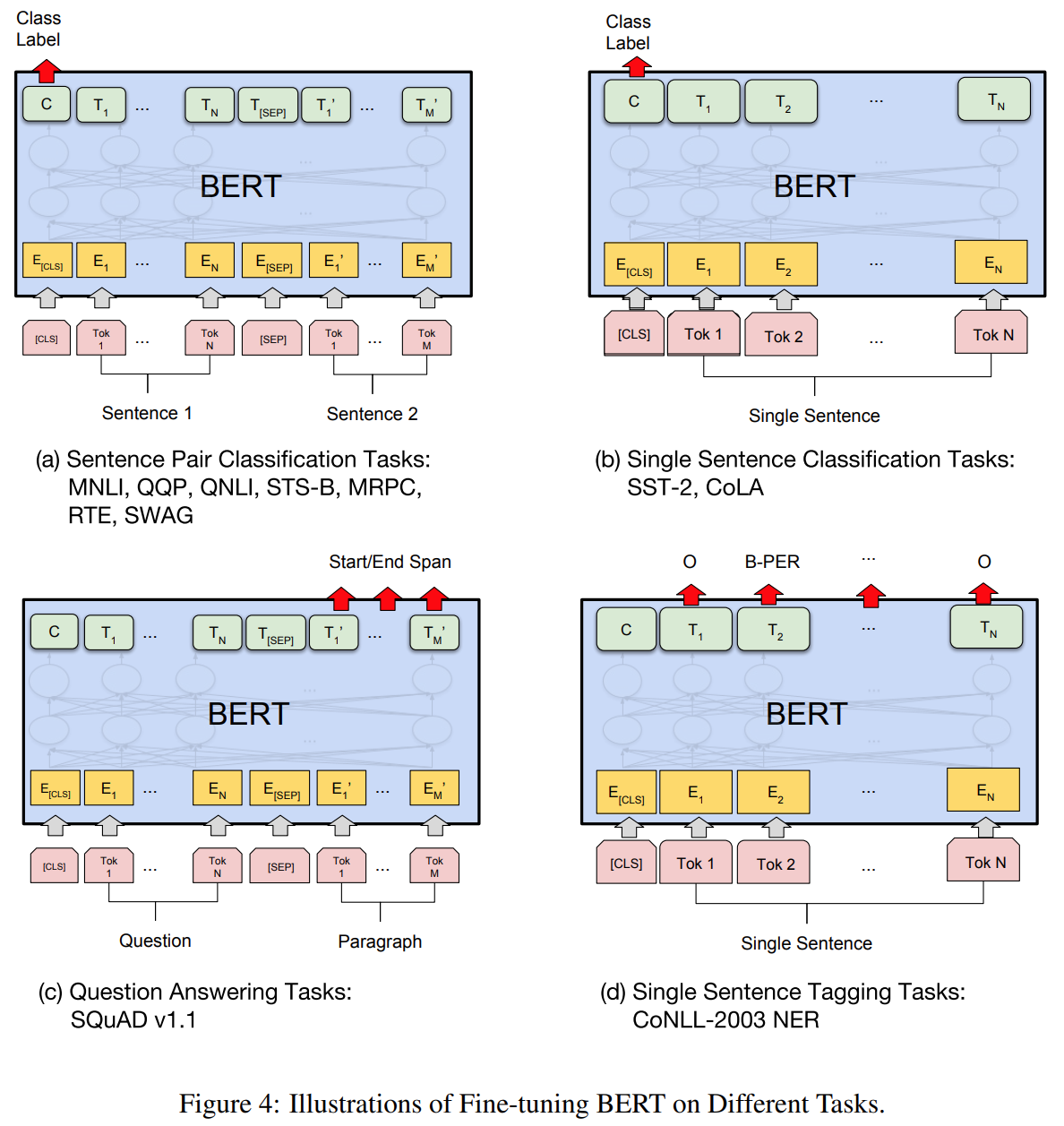

2、微调:

预训练参数初始化,针对不对任务在有标签数据的所有参数微调,不同任务各自单独微调。

三、实验:

1、数据:

GLUE、SQuAD v1.1(问答。损失函数-最大似然,首先在TriviaQA上微调,然后在SQuAD 上微调)、SQuAD v2.0(没有在TriviaQA上微调)、The Situations With Adversarial Generations (SWAG)

99%的人还看了

相似问题

- 最新AIGC创作系统ChatGPT系统源码,支持最新GPT-4-Turbo模型,支持DALL-E3文生图,图片对话理解功能

- 思维模型 等待效应

- FinGPT:金融垂类大模型架构

- 人工智能基础_机器学习044_使用逻辑回归模型计算逻辑回归概率_以及_逻辑回归代码实现与手动计算概率对比---人工智能工作笔记0084

- Pytorch完整的模型训练套路

- Doris数据模型的选择建议(十三)

- python自动化标注工具+自定义目标P图替换+深度学习大模型(代码+教程+告别手动标注)

- ChatGLM2 大模型微调过程中遇到的一些坑及解决方法(更新中)

- Python实现WOA智能鲸鱼优化算法优化随机森林分类模型(RandomForestClassifier算法)项目实战

- 扩散模型实战(十一):剖析Stable Diffusion Pipeline各个组件

猜你感兴趣

版权申明

本文"论文阅读——BERT":http://eshow365.cn/6-27098-0.html 内容来自互联网,请自行判断内容的正确性。如有侵权请联系我们,立即删除!

- 上一篇: 读取Excel的工具类——ExcelKit

- 下一篇: Leetcode—7.整数反转【中等】