已解决

机器学习笔记 - 深度学习中跳跃连接的直观解释

来自网友在路上 161861提问 提问时间:2023-10-23 08:55:12阅读次数: 61

最佳答案 问答题库618位专家为你答疑解惑

一、概述

如今人们利用深度学习做无数的应用。然而,为了理解在许多作品中看到的大量设计选择(例如跳过连接),了解一点反向传播机制至关重要。

如果你在 2014 年尝试训练神经网络,你肯定会观察到所谓的梯度消失问题。简单来说:你在屏幕后面检查网络的训练过程,你看到的只是训练损失停止减少,但距离期望值仍然很远。

1、更新规则和梯度消失问题

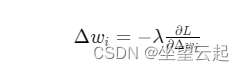

没有动量的梯度下降的更新规则,假设 L 是损失函数,λ是学习率

,其中

,其中

基本上是通过少量更改来更新参数Δwi。它是根据梯度计算的,假设早期层的平均梯度为1e-15 (ΔL/δw)。给定学习率为 1e-4(方程中的 λ),乘积为1e-19,因此,在训练网络时,实际上并没有观察到模型的任何

查看全文

99%的人还看了

相似问题

- PyTorch多GPU训练时同步梯度是mean还是sum?

- 梯度引导的分子生成扩散模型- GaUDI 评测

- 【机器学习】038_梯度消失、梯度爆炸

- 斯坦福机器学习 Lecture2 (假设函数、参数、样本等等术语,还有批量梯度下降法、随机梯度下降法 SGD 以及它们的相关推导,还有正态方程)

- 吴恩达《机器学习》6-4->6-7:代价函数、简化代价函数与梯度下降、高级优化、多元分类:一对多

- 深入理解强化学习——多臂赌博机:梯度赌博机算法的基础知识

- 利用梯度上升可视化卷积核:基于torch实现

- Pytorch里面参数更新前为什么要梯度手动置为0?

- LSTM缓解梯度消失问题

- 前馈神经网络自动梯度计算和预定义算子

猜你感兴趣

版权申明

本文"机器学习笔记 - 深度学习中跳跃连接的直观解释":http://eshow365.cn/6-22326-0.html 内容来自互联网,请自行判断内容的正确性。如有侵权请联系我们,立即删除!