已解决

自注意力机制

来自网友在路上 182882提问 提问时间:2023-09-26 04:16:00阅读次数: 82

最佳答案 问答题库828位专家为你答疑解惑

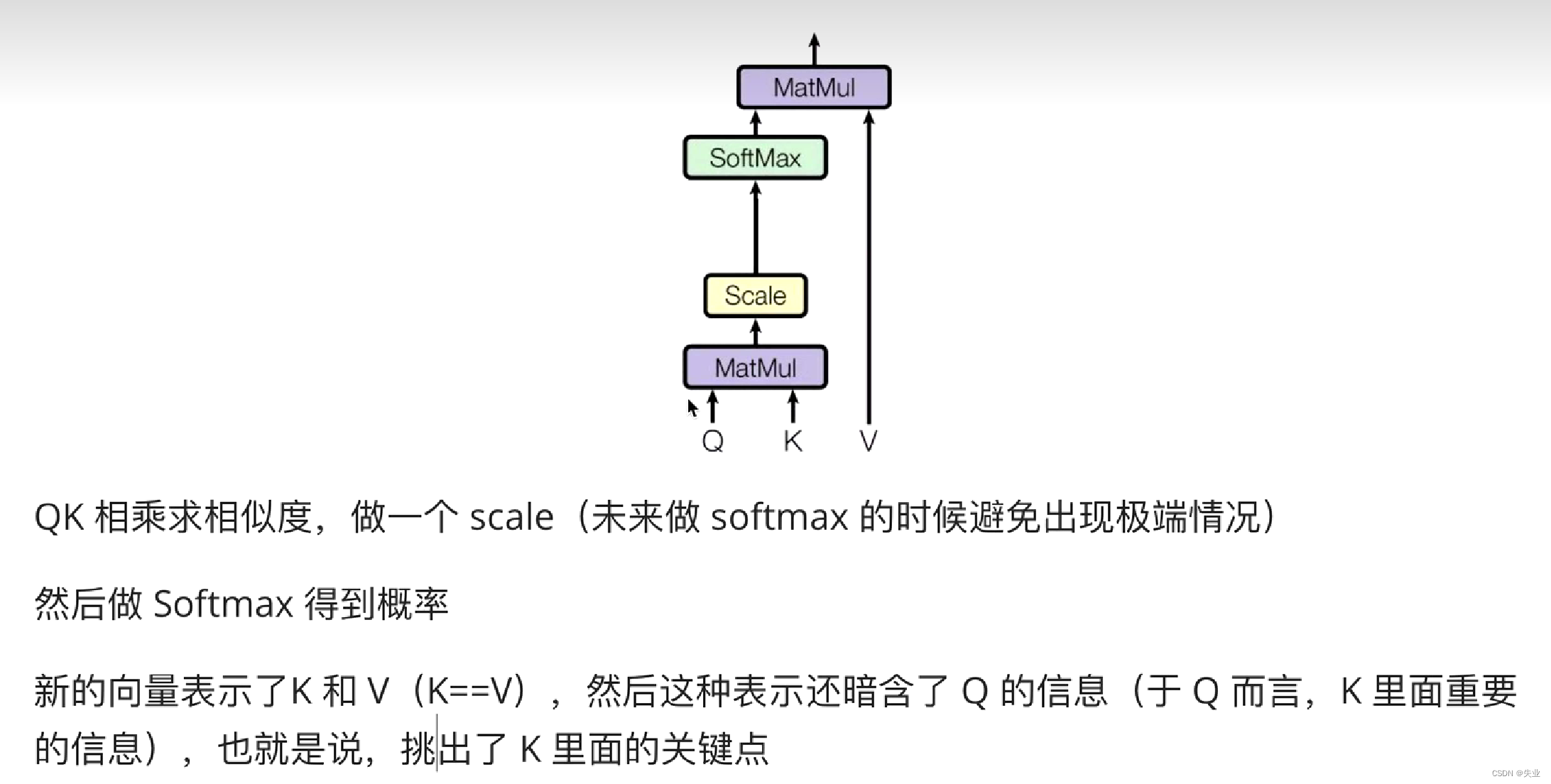

回顾以下注意力机制:

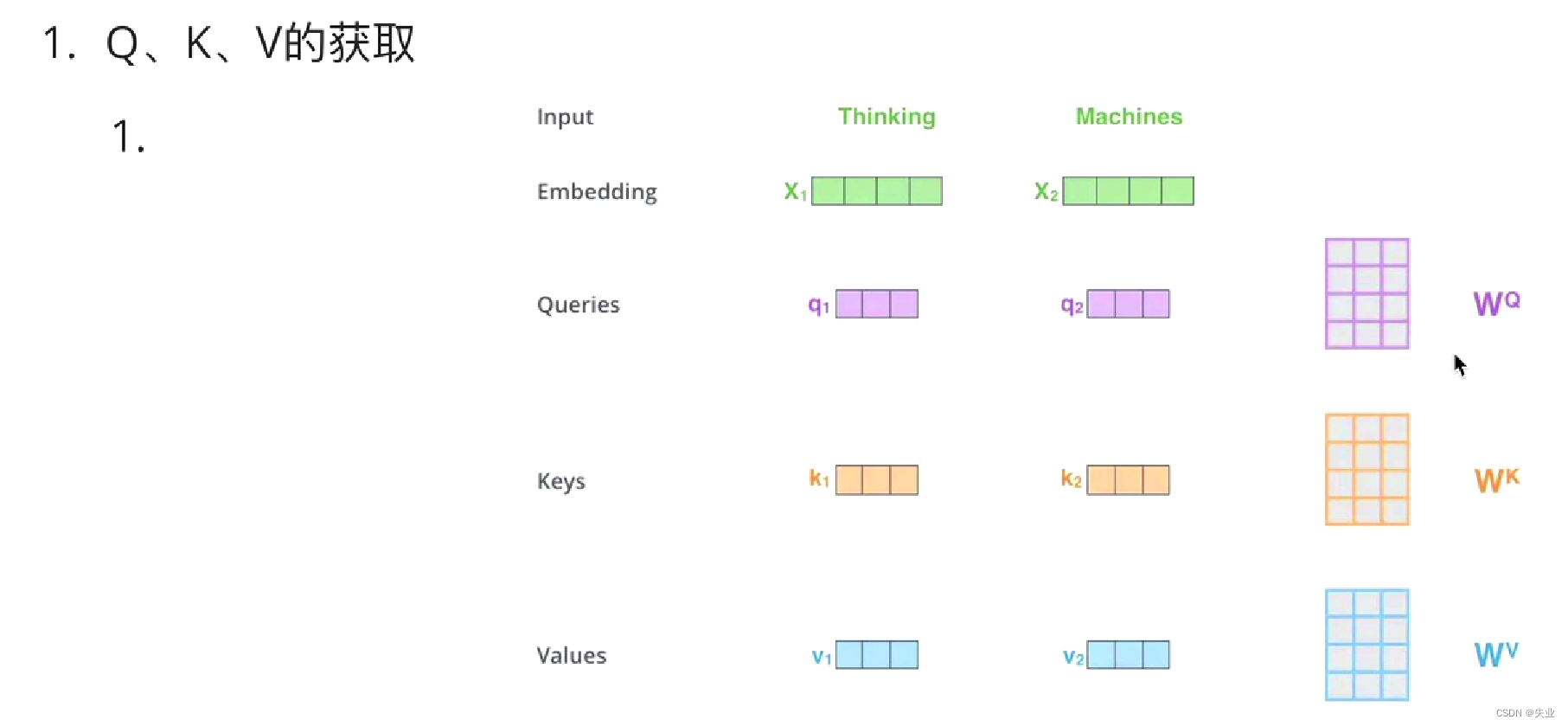

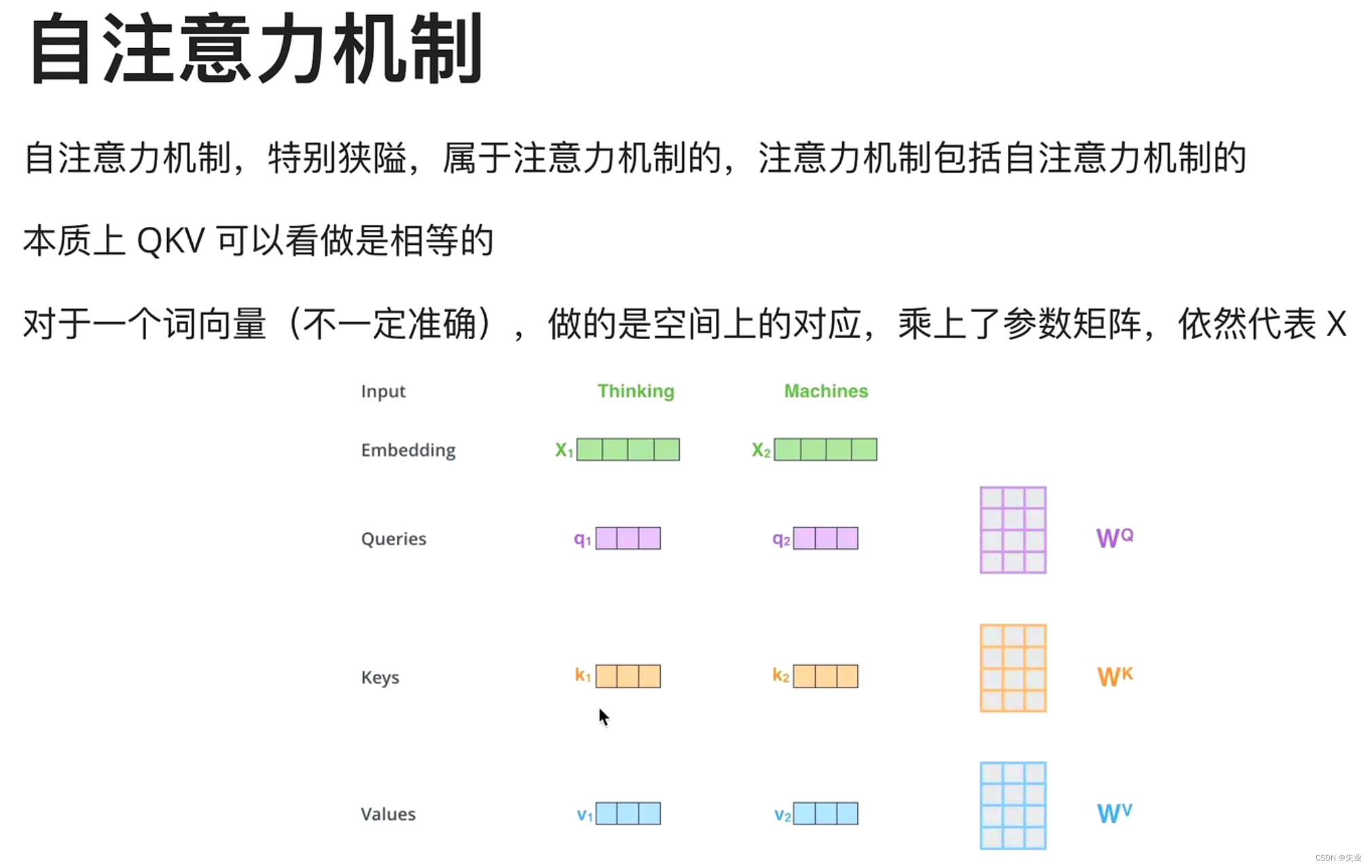

自注意力机制

Self-Attention的关键点 在于

K ≈ \approx ≈V ≈ \approx ≈Q 来源于同一个X,三者是同源的,通过 W Q W_Q WQ, W K W_K WK, W V W_V WV做了一层线性变换。

接下来步骤和注意力机制一模一样。

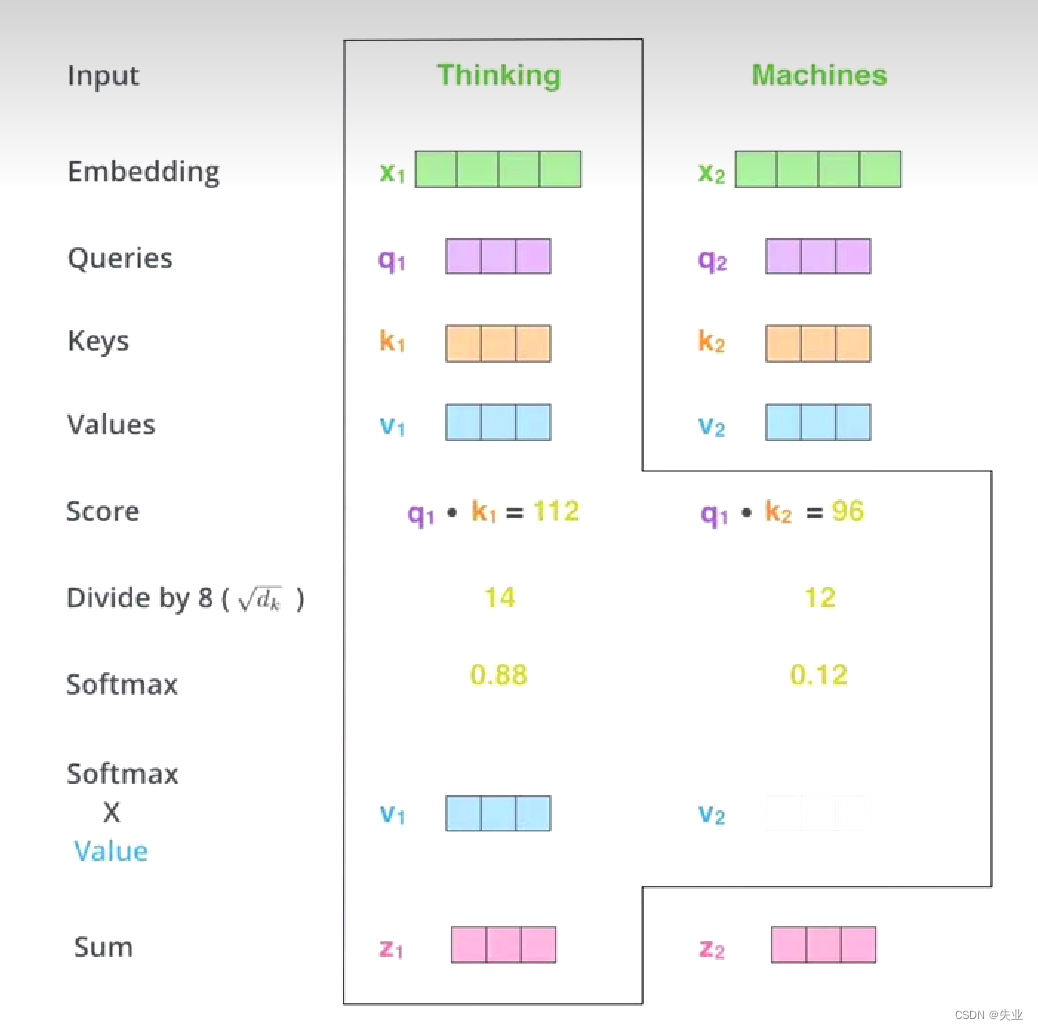

z 1 z_1 z1就是 thinking 的新的向量表示

对于thinking,初始词向量 x 1 x_1 x1

现在我通过thinking machines这句话去查询这句话里的每一个单词和thinking之间的相似度

新的 z 1 z_1 z1依然是thinking的词向量表示,只不过这个词向量表示蕴含了thinking machines这句话对于thinking而言哪个更重要的信息。

不仅规定了QKV同源,还规定了做法。

查看全文

99%的人还看了

猜你感兴趣

版权申明

本文"自注意力机制":http://eshow365.cn/6-13645-0.html 内容来自互联网,请自行判断内容的正确性。如有侵权请联系我们,立即删除!